디아2: 레저렉션, 서버도 터지고 아이템도 날아가고…

디아2 레저렉션 서버가 터졌습니다.

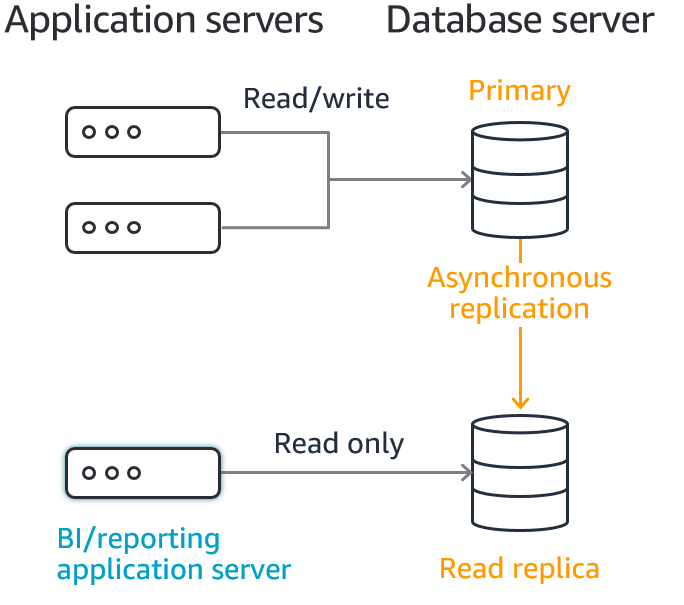

그냥 터지고 게임만 못하면 그나마 다행인데, 몇몇 유저의 게임 진행 내용이 사라졌습니다. 과거 시점으로 롤백 되어버린거죠. 아니 이게 실화인가 싶었는데 와우 유저들에게는 종종 있었던 일이라네요. (그게 더 놀랍네요) 백섭 이라는 용어가 있더군요… https://namu.wiki/w/롤백?from=백섭

다행히 저는 지난 주말에 택배사가 일을 안해서 컴퓨터를 못맞췄고… 게임을 진행하지 않아 백섭 당하지 않았습니다. 여튼 서버가 터지고, 그 시간에 득템을 한사람들, 심지어 득템한걸 거래한 사람들은… 이후에 좋은 템 주우실 거에요… 저도 어제 좀 해봤는데, 기분 탓인지 블쟈가 미안하다고 잠시 템 드랍률을 올린건지… 템이 잘 뜨더라구요.

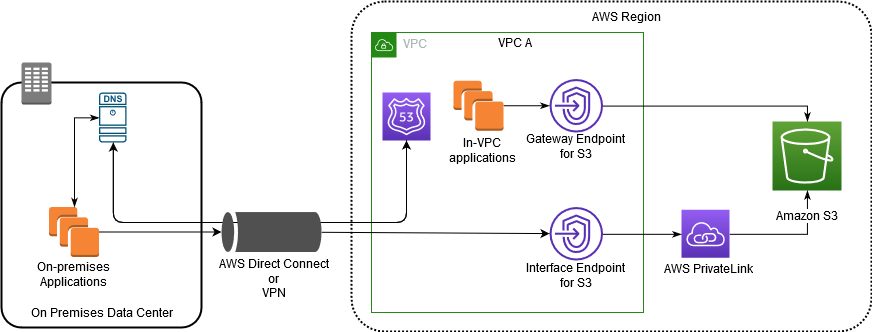

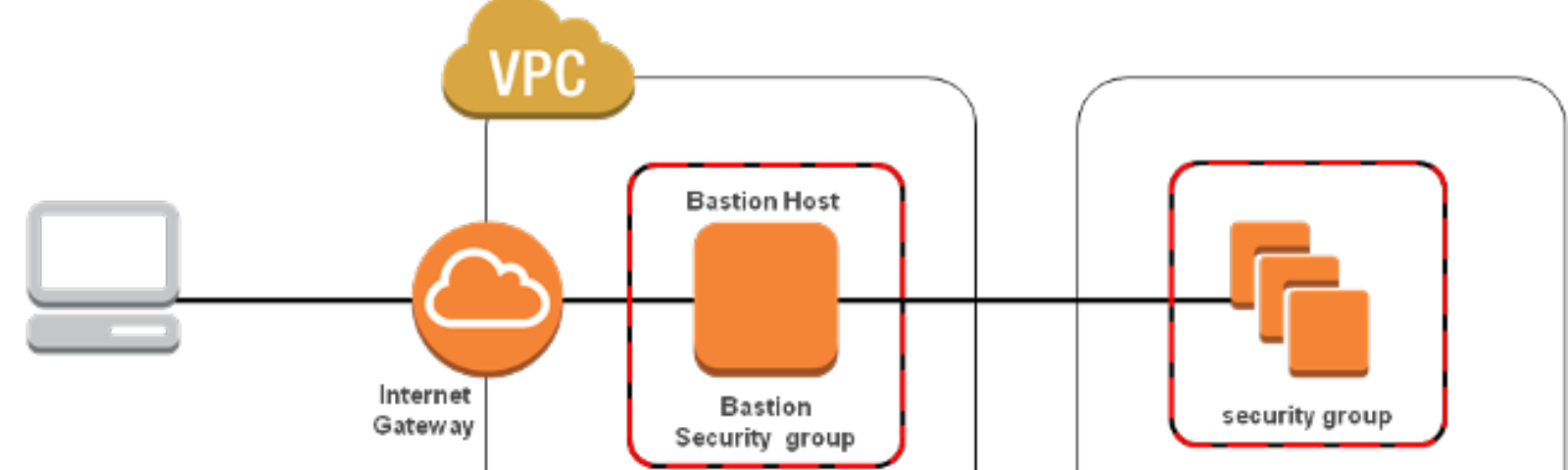

여튼, 도대체 디아블로2 레저렉션 서버가 어떻길래 이런일이 가능한거지? 싶어서 궁금해하던 차에… 블쟈에서 무슨일이 벌어졌던건지 글을 내놓았습니다.